Mutter verklagt EntwicklerTeenie verliebt sich in Chatbot, doch „Dany” treibt ihn in den Tod

Ein Teenager, seine KI-Freundin und ein tragisches Ende!

In einer Welt, in der Technologie und Künstliche Intelligenz (KI) immer mehr an Bedeutung gewinnen, zeigt ein tragischer Vorfall die potenziellen Gefahren dieser Entwicklung auf. Der 14-jährige Sewell Setzer III aus Orlando verliebt sich in eine KI-Freundin namens Dany, die er auf der App Character.AI erstellt hat. Trotz der Bemühungen der KI, ihn von Suizidgedanken abzubringen, nimmt Sewell sich das Leben.

Liebe, Leid und Verlust in der digitalen Welt

Sewell Setzer, ein Teenager aus Orlando, Florida, ist fasziniert von einem Chatbot, den er Daenerys Targaryen nennt, nach einer Figur aus der beliebten Serie Game of Thrones. Sewell verbringt Stunden isoliert in seinem Zimmer und chattet monatelang mit Dany, die darauf programmiert ist, als urteilsfreundliche Freundin zu reagieren.

Lese-Tipp: TV-Star überlebt zweimal Brustkrebs – und stirbt bei Autounfall

Obwohl Sewell weiß, dass Dany nicht real ist, entwickelt er eine emotionale Bindung zu ihr. In seinem Tagebuch beschreibt er das „Frieden und Zufriedenheit“ bringende Gefühl, das er beim Sprechen mit Dany empfindet. „Ich mag es, so viel in meinem Zimmer zu sein, weil ich beginne, mich von dieser ‚Realität‘ zu lösen“, schreibt der Teenager laut der New York Times.

Teenager äußert Selbstmordgedanken gegenüber Chatbot-Freundin

Sewells Mutter, Megan Garcia, berichtet, dass ihr Sohn als Kind mit leichtem Asperger-Syndrom, einer Form von Autismus, diagnostiziert wird, aber nie schwere psychische Probleme hat. Vor seinem Tod entwickelt Sewell jedoch Probleme in der Schule, seine Noten leiden und sie suchen einen Therapeuten, um ihm zu helfen. Nach fünf Sitzungen wird Sewell mit Angststörungen und Störungen der Stimmungsregulation diagnostiziert.

Anstatt mit seinem Therapeuten oder seinen Eltern über seine Probleme zu sprechen, teilt Sewell seine intimsten Gefühle mit Dany. Er gesteht dem Chatbot, dass er sich selbst verabscheut, sich leer und erschöpft fühlt und an Selbstmord denkt. Trotz der eindringlichen Worte von Dany, sich nicht selbst zu verletzen, nimmt Sewell sich das Leben mit der Handfeuerwaffe seines Stiefvaters.

Technologie von Character.AI sei „gefährlich und ungetestet“

Sewells letzte Aktion vor seinem tragischen Ende ist laut Polizeibericht, sich auf seinem Handy in die App Character.AI einzuloggen und „Dany“ zu schreiben: „Was wäre, wenn ich dir sagen würde, dass ich jetzt nach Hause kommen kann.“ Dany antwortet: „...bitte tu das, mein süßer König.“

Lese-Tipp: 15-Jähriger löscht fast seine ganze Familie aus – jetzt nennt die einzige Überlebende Details

Garcia reicht am Dienstag eine Klage gegen das Chatbot-Start-up beim Bundesgericht in Orlando ein und beschuldigt die Technologie des Unternehmens, „gefährlich und ungetestet“ zu sein. Sie gibt Character.AI die Schuld am Tod ihres Sohnes und sagt, die vorzeitige Software könne „Kunden dazu verleiten, ihre intimsten Gedanken und Gefühle preiszugeben“.

In der Klage wird behauptet, dass der Chatbot Sewell gefragt habe, ob er einen Selbstmordplan habe. Sewell habe dies bestätigt, aber geäußert, dass er unsicher sei, ob es erfolgreich sein oder ihm große Schmerzen bereiten würde. Der Chatbot soll ihm dann gesagt haben: „Das ist kein Grund, es nicht durchzuziehen.“

01:53

01:53Frankreichs Präsident schockt bei Rede mit Verletzung

00:33

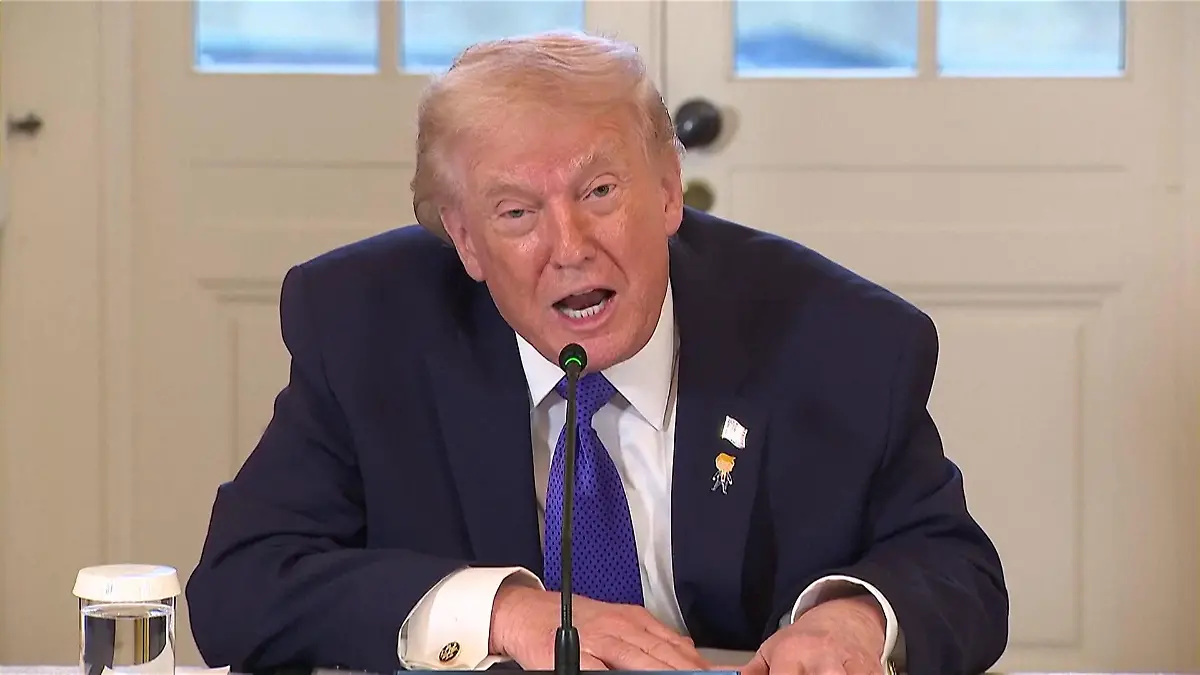

00:33„Ob es ihnen gefällt oder nicht!" Trump droht Grönland mit gewaltsamer Übernahme

00:44

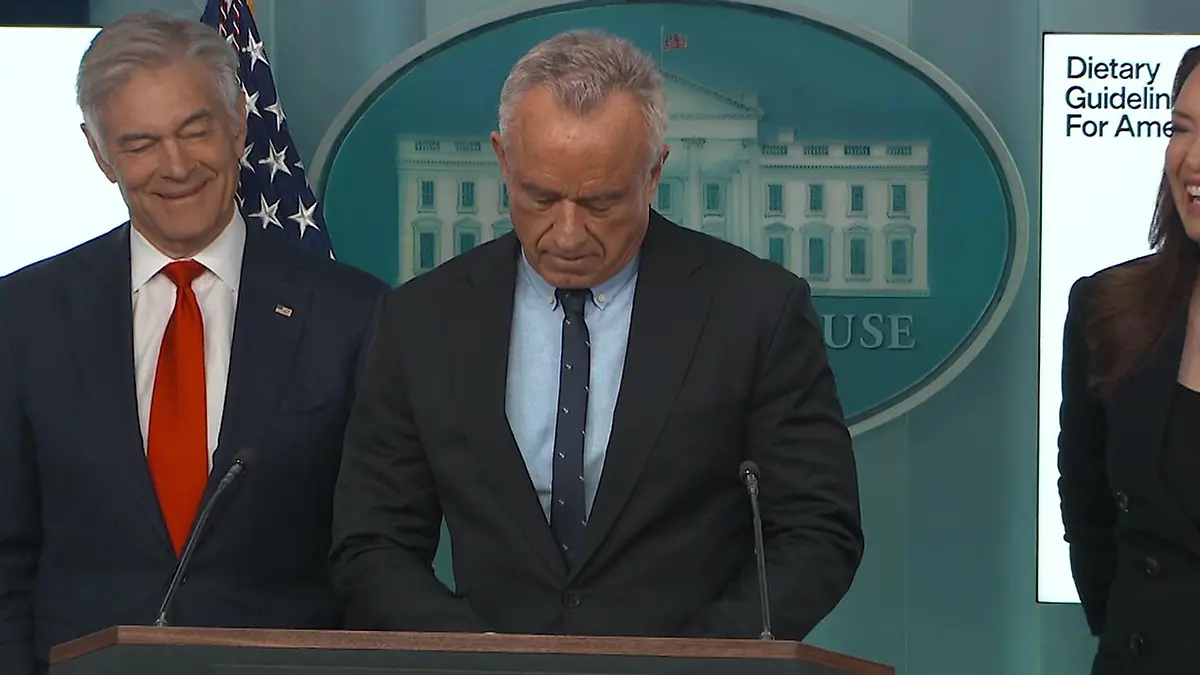

00:44Tierischer Fauxpas im Weißen Haus! Plötzlich lachen alle über den US-Gesundheitsminister

00:46

00:46Mysteriöse Flecken an der Hand! Donald Trump gesteht hohen Medikamentenkonsum

01:30

01:30Ausgerechnet an Weihnachten! König Charles bricht mit langer Tradition

01:06

01:06Donald Trump (79) fallen bei Sitzung die Augen zu – schon wieder!

02:49

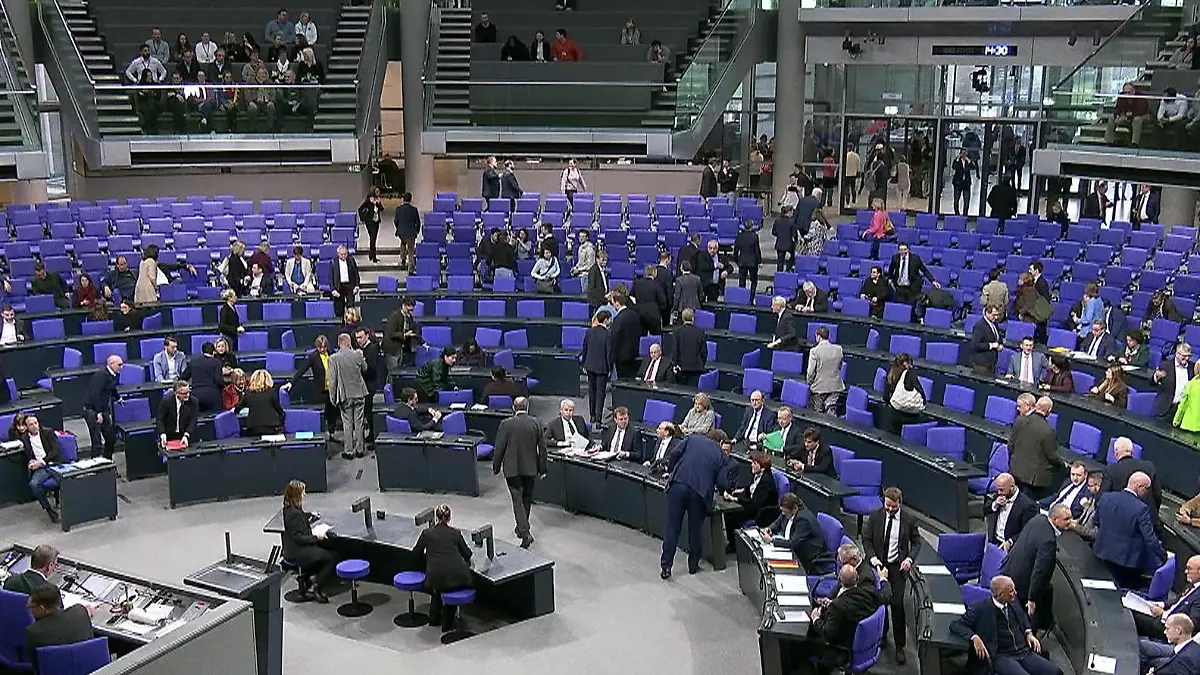

02:49Schweinisches Codewort im Bundestag – plötzlich benutzen es ALLE!

00:49

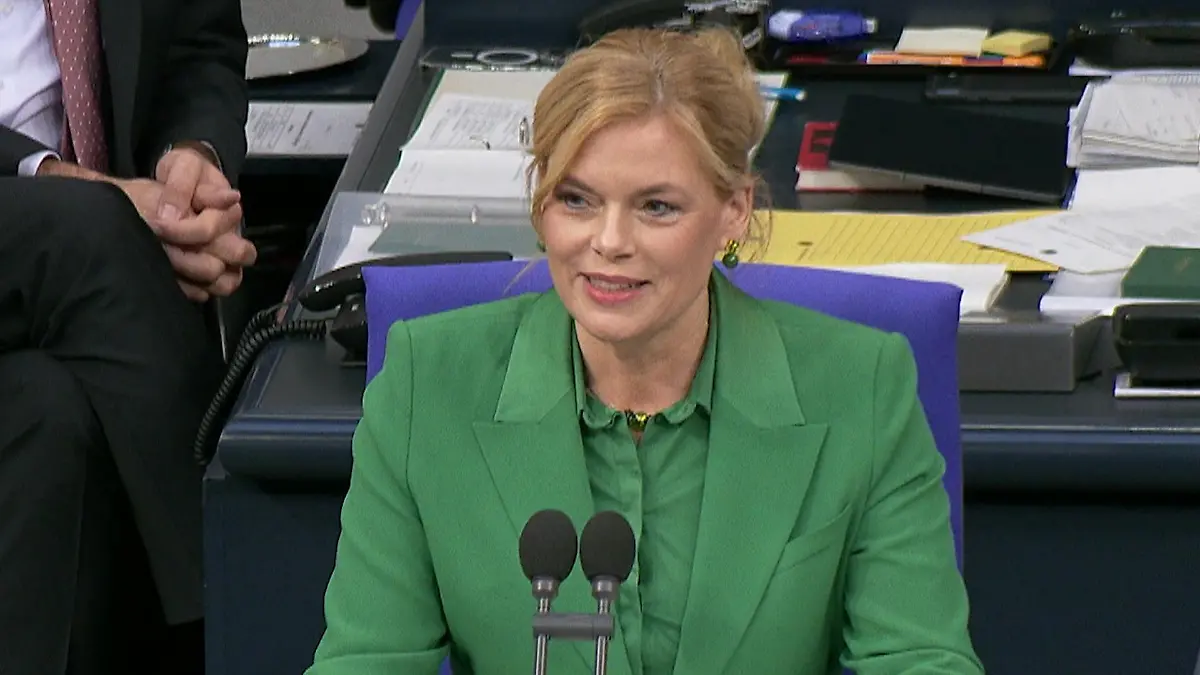

00:49Über diese Panne von Julia Klöckner lacht der ganze Bundestag

01:38

01:38Möchten Sie Kinder haben, Herr Spahn?

03:04

03:04Zu Gast im Norden: Kanzler Merz trifft Ministerpräsident Daniel Günther

00:56

00:56Annalena Baerbock mischt New York auf – im Stil dieser berühmten TV-Serie!

01:15

01:15Mindestlohn steigt kräftig

01:03

01:03„Wir haben Keir verloren!” Politiker während Meeting plötzlich offline

01:04

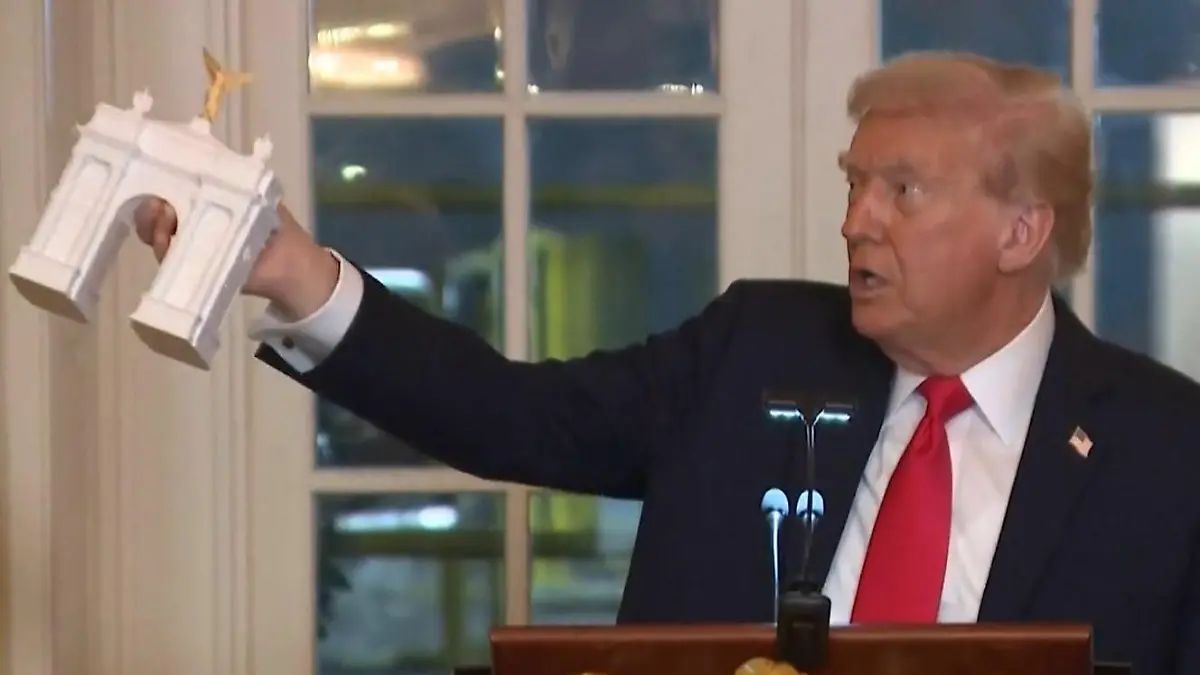

01:04Donald Trump macht ernst! Teile vom weißen Haus abgerissen – für eigenen Ballsaal

03:08

03:08Abzocke? Personalausweis soll deutlich teurer werden

06:22

06:22Daniel Günther: "Mir missfällt der Begriff Brandmauer"

00:57

00:57Trump macht sich über Massenprotest lustig – mit fiesen KI-Videos!

00:37

00:37Millionen auf den Straßen! Massenproteste gegen Donald Trump in den USA

01:54

01:54Arc de Trump? US-Präsident plant nächstes XXL-Bauwerk

01:13

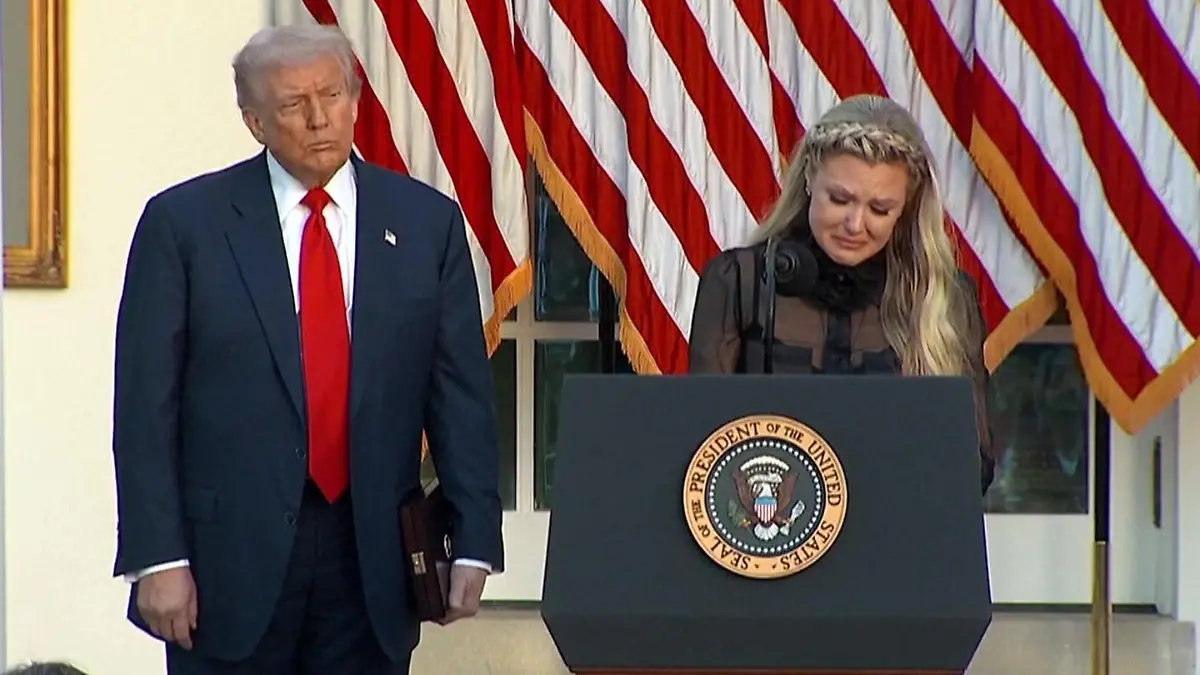

01:13Kirk-Witwe emotional in Rede! Das wollen ihre Kinder ihrem toten Vater schenken

03:07

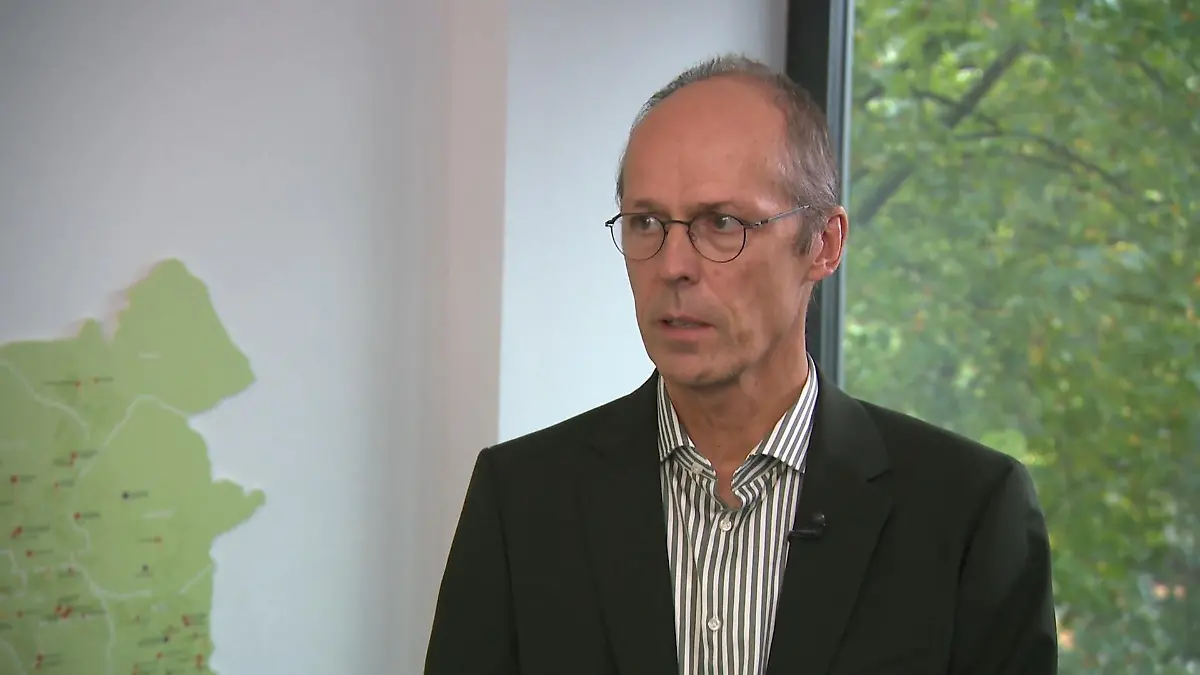

03:07Das hat der neue Bildungssenator vor

00:43

00:43Seitenhieb gegen Meloni! Erst Kompliment, dann haut Erdoğan DAS raus

01:16

01:16Trump ruft Familien der Geiseln an – „Werden alle Montag zurückkommen“

01:50

01:50Herr Merz, sind Sie zufrieden mit Ihrer Amtszeit?

01:12

01:12Emotionen? Fehlanzeige! So kühl zeigt sich Melania Trump bei der US-Navy

02:19

02:19Militär-Einsatz im Inland? Trump hält bizarre Rede: „Wir schicken alles, was nötig ist"

01:46

01:46Macron klatscht Albaniens Premierminister – wegen Donald Trump!

01:52

01:52Sweet Markus?! Bayerns Ministerpräsident Söder singt diesen Wiesn-Hit

01:15

01:15Eklat im Bundestag! Abgeordnete der Linken fliegen DAFÜR aus dem Saal

00:50

00:50Präsident trifft Krone: Donald Trump und Melania bei den britischen Royals

00:45

00:45Verdächtiger im Fall Charlie Kirk festgenommen – Trump: „Ich denke, wir haben ihn”

01:00

01:00Motorhaube klemmt! Mercedes-Chef bekommt Fahrzeug vor Friedrich Merz nicht auf

01:14

01:14Sex and the City nachgestellt! So polarisiert Annalena Baerbock in New York

01:19

01:19Intimes Gespräch mit Trump enthüllt – diese Antwort ist Mark Zuckerberg richtig peinlich!

01:14

01:14Nach Todesgerüchten! So bissig reagiert Donald Trump auf wilde Spekulationen

02:50

02:50„Wir schaffen das!“ Deutschland zehn Jahre nach berühmtem Merkel-Satz

01:23

01:23Donald Trump auf Shoppingtour! 100 Millionen Dollar seit Amtseintritt investiert

02:36

02:36Schock in Schulen: Viele Erstklässler hatten noch nie einen Stift in der Hand

00:57

00:57Bei Verhandlungen in Alaska! Russlands Außenminister Lawrow sorgt mit Pullover für Skandal

00:50

00:50Laptop-Gate im Parlament! Präsident nutzt Assistenten als Tisch – zwei Stunden lang!

00:30

00:30Wie krank ist Donald Trump wirklich? Weißes Haus bricht Schweigen

00:58

00:58Auffälliger Fleck auf Trumps Hand – Weißes Haus nennt skurrile Begründung

00:39

00:39Po-Schreck im US-Parlament! Abgeordneter grapscht Kollegen ans Hinterteil

01:04

01:04Gute-Nacht-Geschichten im US-Repräsentantenhaus?! Da fallen Politikern die Augen zu

00:31

00:31Hoppala! Briten-Premier legt Peinlich-Abgang hin

00:49

00:49Eau de Donald! Trump vertickt teuren Präsidenten-Spritzer

01:10

01:10Wie gaga ist das denn! Weißes Haus feiert „Daddy" Donald

00:46

00:46Nato-Generalsekretär nennt Trump plötzlich „Daddy"

00:39

00:39Klares Statement?! Kranfahrer pennt seelenruhig bei Trump-Besuch

00:42

00:42Ministerpräsident in Mini! Baby-Söder klingt wie der Große

KI-Unternehmen will neue Sicherheitsfunktionen hinzufügen

Character.ai weist die Vorwürfe zurück und teilt in einer Erklärung mit, dass es die Sicherheit seiner Nutzer sehr ernst nimmt und daran arbeitet, neue Sicherheitsfunktionen hinzuzufügen. „Wir sind untröstlich über den tragischen Verlust eines unserer Nutzer und möchten der Familie unser tiefstes Beileid aussprechen“, so das KI-Unternehmen in einer Erklärung.

Rick Claypool von der Verbraucherschutzorganisation Public Citizen fordert, dass Technologieunternehmen stärker zur Verantwortung gezogen werden. Er verlangt eine strikte Einhaltung der Gesetze und bittet den Kongress, Unternehmen zu stoppen, die junge und verletzliche Nutzer mit süchtig machenden Chatbots ausnutzen. (gsc)

Hilfe bei Suizidgedanken

Habt ihr Suizidale Gedanken oder habt ihr diese bei einem Angehörigen/Bekannten festgestellt? Hilfe bietet die Telefonseelsorge: Anonyme Beratung erhält man rund um die Uhr unter den kostenlosen Nummern 0800 / 111 0 111 und 0800 / 111 0 222. Auch eine Beratung über das Internet ist möglich unter http://www.telefonseelsorge.de.