Und sie behalten die pikanten Geheimnisse nicht mal für sichIntimer Cyber-Lauschangriff: Alexa, Siri und Co. hören uns beim Sex zu!

Eigentlich sollen Sprachassistenten wie der von Google, die „Alexa“ von Amazon oder „Siri“ von Apple nur dann aktiviert werden, wenn bestimmte Triggerwörter wie „Ok Google“, „ Alexa" oder "Siri" genannt werden. Eine Studie der Ruhr-Universität Bochum und des Bochumer Max-Planck-Instituts für Sicherheit zeigt nun jedoch: Die Sprachassistenten hören viel häufiger mit, als uns bewusst und lieb ist – auch in besonders intimen Momenten.

Diese falschen Triggerwörter aktivieren "Alexa" und "Siri"

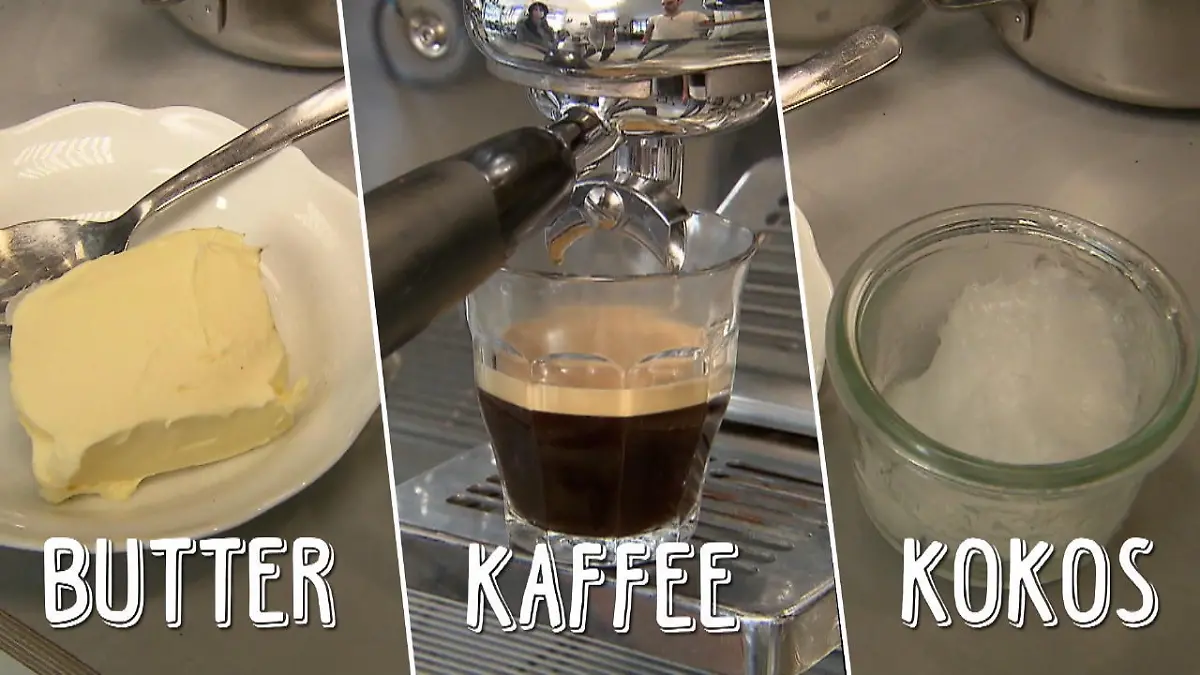

Die Forscher untersuchten elf Smart-Lautsprecher, unter anderem die in Deutschland beliebten Modelle von Amazon, Apple und Google sowie Geräte von chinesischen Firmen wie Xiaomi oder Baidu. 16 Tage lang beschallten die Wissenschaftler die Speaker mit unterschiedlichem Tonmaterial: von TV-Serien und Nachrichten über spezielle Tondatenbanken. Dabei stellten sie fest: 735 Mal hörten die Assistenten zu, ohne dass die Benutzer sie vorher bewusst aktiviert hatten. Statt mit dem Triggerwort „Amazon“ wurde die Alexa unter anderem mit den Wörtern „Am Sonntag“ aktiviert. „Siri“ fühlte sich beispielsweise durch das Wort „Daiquiri“ angesprochen.

Sprachassistenten belauschen uns beim Sex

Auch beim Liebesspiel hören die Sprachassistenten versehentlich mit, wie eine ehemalige Apple-Mitarbeiterin im Interview mit „STRG_F“ berichtet. Die Geräte fühlten sich beim Sex angesprochen, weil sie bestimmte während des Akts gesprochene Wörter versehentlich als Aktivierungswort wahrgenommen würden, so die anonyme Ex-Mitarbeiterin. Das passiere vor allem, wenn der Assistent sich in nächster Nähe des Aktes befinde.

Was passiert mit unseren Sprachaufnahmen?

Mit ein wenig Pech behalten die Sprachassistenten unsere pikanten Geheimnisse nicht mal für sich. Denn viele Unternehmen beschäftigen spezielle Mitarbeiter, sogenannte Transkriptoren, die einen Teil unserer Sprachbefehle anhören und auswerten sollen, um die Spracherkennung zu verbessern. Laut Recherchen von „STRG_F“ sollen davon etwa 1% der Aufnahmen betroffen sein.

+++ Neue Alexa-Funktionen: Ist das jetzt das neue Stalking-Tool? +++

So schützen Sie sich vor ungewollten Lauschangriffen

Amazon-Kunden können beispielsweise in ihrem Account einsehen, welche Befehle von „Alexa“ verarbeitet wurden – und unerwünschte Mitschnitte löschen. Doch schon vor der Aufzeichnung gibt es Möglichkeiten, zu verhindern, dass die Geräte zu viel Privates mitschneiden.

Stellen Sie das Mikrofon ihres Smart Speakers auf stumm oder schalten Sie das Gerät komplett aus, wenn Sie Aufnahmen in bestimmten Situationen verhindern wollen. Auch das Gerät in einen anderen Raum zu stellen, kann versehentliche Mitschnitte verhindern. Bei Amazon haben Sie zudem die Möglichkeit, der Nutzung Ihrer Sprachaufzeichnungen zu widersprechen. Bei Apple müssen die Nutzer sogar aktiv ihre Zustimmung geben, bevor ihre Aufnahmen zur Verbesserung genutzt werden dürfen.